Искусственный интеллект требует новых стандартов безопасности

Развитие искусственного интеллекта опережает создание систем защиты — новые технологии открывают пространства для злоумышленников быстрее, чем появляются средства противодействия. Коммерческие институты совместно с регуляторами разрабатывают специализированные фреймворки и стандарты, включая работу консорциума "Исследований безопасности технологий ИИ".

Российское регулирование безопасности ИИ базируется на нескольких ключевых документах. Указ о развитии искусственного интеллекта определяет доверенные технологии ИИ как системы, "отвечающие стандартам безопасности, исключающие возможность причинения вреда человеку и нарушения его основополагающих прав". Документ устанавливает цели развития ИИ — обеспечение национальной безопасности и достижение лидирующих позиций в мире.

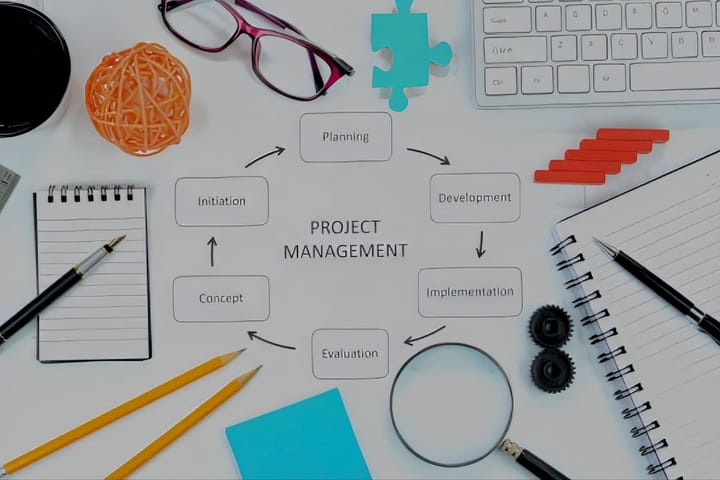

ПНСТ 836-2023 "Функциональная безопасность и системы искусственного интеллекта" вводит принципиально новые подходы к оценке рисков. Стандарт определяет безопасность как "отсутствие неприемлемого риска", а риск — как "сочетание вероятности события причинения вреда и тяжести этого вреда". Документ описывает трехступенчатый принцип реализации систем ИИ: сбор данных, машинное обучение и обработка выходных данных.

Стандарт разделяет элементы технологий ИИ на уровни использования. Для элементов высокого уровня — графов приложений и ML-моделей — применяются специфические характеристики безопасности, отличающиеся от традиционных систем. Элементы низкого уровня подчиняются существующим стандартам функциональной безопасности.

ГОСТ Р 59898-2021 определяет субхарактеристики защищенности систем ИИ, которые кардинально отличаются от стандартных свойств информационной безопасности — конфиденциальности, целостности и доступности. Это подчеркивает специфичность безопасности в контексте использования нейросетей и машинного обучения.

Документы охватывают весь жизненный цикл систем ИИ — от проектирования до эксплуатации, но остаются на уровне общих требований. Специализированного стандарта, посвященного исключительно безопасности ИИ, в России пока не существует.

В перспективе ожидается появление детализированных стандартов с практическими методиками, измеримыми метриками и учетом специфики различных типов систем искусственного интеллекта. Развитие регулирования должно поспевать за стремительным прогрессом технологий.